уряд Сьогодні Сінгапур випустив план глобального співробітництва в галузі безпеки в галузі штучного інтелекту після зустрічі дослідників ШІ в США, Китаї та Європі. Документ пропонує спільне бачення досягнення безпеки AI за допомогою міжнародного співробітництва, а не конкуренції.

“Сінгапур – одна з небагатьох країн на землі, яка добре ладила зі Сходом”, – сказав Макс Тегмарк, вчений MIT. “Вони знають, що не будують його”. [artificial general intelligence] Вони самі – вони зроблять це з ними – тому дуже цікаво встановити країни, які розмовляють один з одним. ”

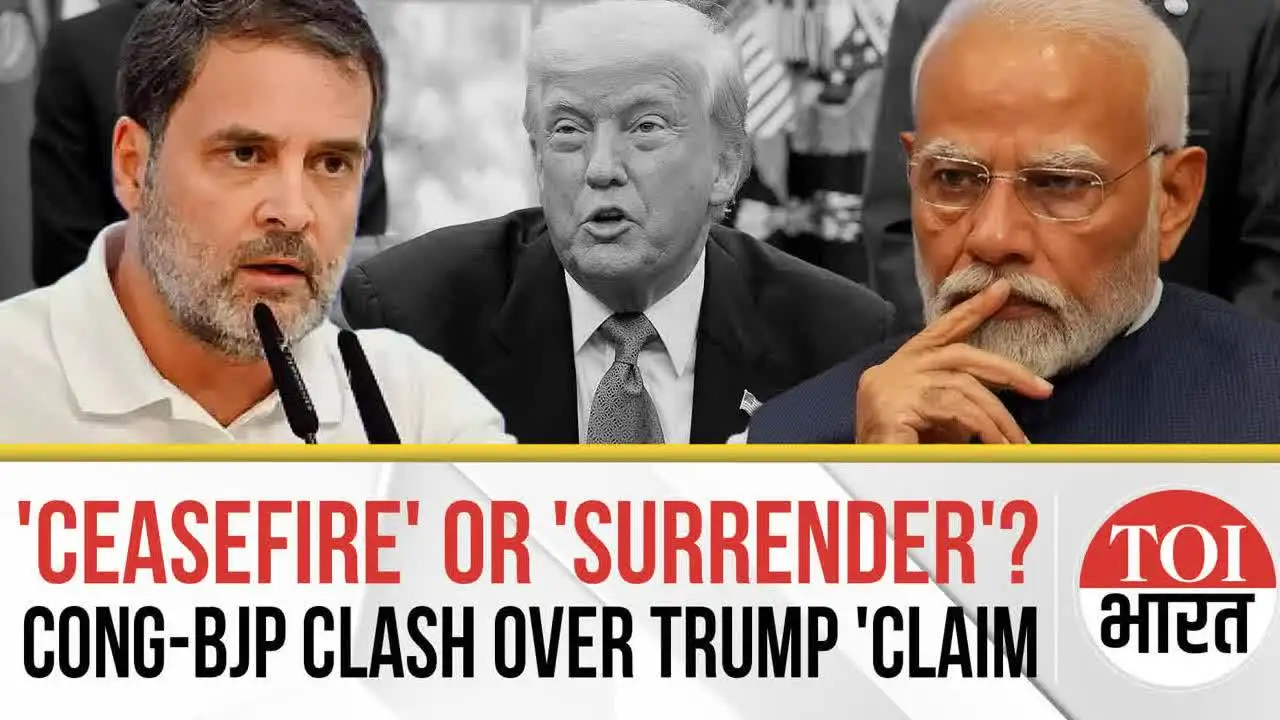

Ці країни вважають, що країни, які, швидше за все, будують AGI, звичайно, є США та Китаєм, але ці країни, здається, готові перевершити один одного, ніж працювати разом. У січні, після того, як китайський стартап Deepseek випустив передову модель, президент Трамп назвав це “розбудити нашу галузь” і заявив, що США потрібно “перемогти з лазерами як зосередження уваги на конкуренції”.

Сінгапур досяг консенсусу щодо пріоритетів для глобальних досліджень безпеки AI, що вимагає від дослідників співпрацювати в трьох ключових сферах: вивчення ризиків, спричинених кордоном моделей AI, вивчення безпечніших методів побудови цих моделей та розробки методів контролю за поведінкою сучасних систем AI.

Консенсус був утворений 26 квітня на засіданні великої події AI, що відбулася в Сінгапурі разом з Міжнародною конференцією з представників навчання (ICLR).

Дослідники з OpenAI, Antropic, Google Deepmind, XAI та META взяли участь у заходах з безпеки AI, а вчені з таких установ, як MIT, Stanford, Tinghua та Китайської академії наук, також брали участь у заходах з питань безпеки ШІ. Експерти з питань безпеки AI у США, Великобританії, Франції, Канаді, Китаї, Японії та Південній Кореї також взяли участь у засіданні.

“В епоху геополітичного підрозділу всебічна інтеграція передових досліджень щодо безпеки AI є перспективним сигналом про те, що глобальні громади приєднуються до спільної прихильності до формування безпечнішого майбутнього AI”,-заявив у заяві керівник університету Цінхуа Сюе Лан.

Розробка все більш здібних моделей AI, деякі з яких мають дивовижні здібності, поставили дослідників на страх перед низкою ризиків. Незважаючи на те, що деякі зосереджені на останніх шкодах, включаючи проблеми, спричинені упередженими системами ШІ або потенціалом злочинців використовувати технологію, велика кількість людей вважає, що ШІ може становити екзистенційну загрозу для людей, коли вона починає тривати все більше людей. Цих дослідників іноді називають “руйнівниками AI” і побоюються, що моделі можуть обманювати та маніпулювати людьми у досягненні власних цілей.

Потенціал ШІ також викликав дискусії про гонку зброї між США, Китаєм та іншими потужними країнами. Ця технологія розглядається в політичній спільноті як вирішальне значення для економічного процвітання та військового панування, і багато урядів намагаються розробити власне бачення та правила, щоб сформулювати, як вони розвиваються.

Leave a Reply